Por que a transparência e a responsabilidade são essenciais na inteligência artificial?

Desvendando as implicações da IA Generativa (Gen AI) e como inovar de forma responsável

.jpg)

A inteligência artificial (IA) está rapidamente transformando diversos setores, incluindo a indústria de transportes. Sistemas telemáticos alimentados por IA estão revolucionando a gestão de frotas, oferecendo insights valiosos sobre o comportamento do motorista, desempenho do veículo e otimização de rotas. Essa abordagem baseada em dados não só aumenta a eficiência operacional, como também a segurança geral dos motoristas. No entanto, com o crescente uso da IA, aumenta a necessidade de garantir que esses sistemas sejam usados de forma ética, responsável e transparente. É crucial entender como a IA funciona, como as decisões são tomadas e quais as implicações para os indivíduos e a sociedade como um todo.

O que são transparência e responsabilidade em IA?

Transparência em IA significa que podemos entender como um sistema de IA funciona. É como ter acesso aos bastidores de um truque de mágica: saber quais dados a IA usa, como toma decisões e quais são suas limitações. Isso permite identificar potenciais vieses ou erros, aumentando a confiança nos resultados do sistema.

Responsabilidade em IA significa definir claramente quem é responsável pelas decisões tomadas por um sistema de IA. Isso pode incluir os desenvolvedores, as organizações que o utilizam e até os indivíduos afetados por suas decisões. A responsabilidade vai além de atribuir culpa; trata-se de garantir que haja responsabilidade em cada etapa do ciclo de vida da IA.

A importância da supervisão humana na IA

A supervisão humana é crucial para garantir que a IA seja usada de forma segura e ética. Isso inclui:

- Aquisição responsável: selecionar sistemas de IA alinhados com princípios éticos e de sustentabilidade.

- Desenvolvimento ético: projetar e construir sistemas de IA com justiça, transparência e responsabilidade.

- Implantação cuidadosa: implementar sistemas de IA minimizando riscos e maximizando benefícios.

Monitoramento contínuo: avaliar continuamente os sistemas de IA para garantir que estejam funcionando como esperado e para lidar com quaisquer consequências não intencionais.

Para fortalecer ainda mais a responsabilidade, as organizações podem utilizar a supervisão externa. Isso pode ser feito através de:

- Auditorias independentes: especialistas externos avaliam os sistemas de IA para garantir que atendam aos padrões éticos.

- Monitoramento governamental: trabalhar com reguladores para garantir a conformidade com leis e diretrizes relevantes.

- Transparência pública: comunicar abertamente ao público sobre os sistemas de IA e como estão sendo usados

Abrindo a Caixa Preta: Tornando a IA Transparente e Responsável

Sem transparência, responsabilidade e supervisão humana, a IA pode se tornar uma "caixa preta", tomando decisões que não entendemos e não podemos explicar. Isso pode levar a uma série de problemas, incluindo:

- Vieses e discriminação: sistemas de IA podem perpetuar e amplificar preconceitos existentes.

- Falta de confiança: se as pessoas não entendem como a IA funciona, podem ter menos confiança nela.

- Mau uso e abuso: sem responsabilidade, a IA pode ser usada para fins prejudiciais.

Operacionalizando Ética da IA

Para garantir o uso ético e responsável da IA, podemos adotar as seguintes medidas:

- IA Explicável (XAI): Pesquisadores estão desenvolvendo técnicas para tornar a IA mais transparente e explicável. Isso envolve a criação de sistemas de IA que podem fornecer explicações claras para suas decisões, de uma forma que os humanos possam entender.

- Auditoria e monitoramento: Auditar regularmente os sistemas de IA pode ajudar a identificar problemas em potencial e garantir que eles estejam sendo usados de forma responsável.

- Diretrizes e regulamentos éticos: Desenvolver diretrizes e regulamentos éticos claros para a IA pode ajudar a garantir que ela seja usada para o bem e que aqueles que desenvolvem e implantam sistemas de IA sejam responsabilizados.

- Educação pública: É importante educar o público sobre a IA, seus benefícios potenciais e seus riscos. Isso ajudará a construir confiança na IA e garantir que ela seja usada de uma forma que beneficie a todos.

Uso responsável e transparente da IA: transformando o futuro com ética e supervisão humana

Ao adotar os princípios de responsabilidade, transparência e supervisão humana, podemos garantir que a IA seja utilizada de forma ética e responsável, beneficiando a todos. A IA tem um potencial enorme para transformar o mundo de maneira positiva, mas é crucial que seu desenvolvimento e implementação sejam guiados por princípios éticos sólidos.

Quer saber mais sobre como a IA pode ser utilizada de forma responsável e transparente? Solicite uma demonstração e descubra como podemos ajudá-lo a implementar soluções de IA seguras e eficazes em sua empresa.

Fique por dentro das novidades do setor e dicas da Geotab

Cyber Risk Advisor and Data & Technology Enthusiast with over a decade of experience delivering transformative projects in the financial services and insurance industries. As a respected privacy and AI risks advisor, FX leads the development of comprehensive action plans to address privacy risks in the AI era. With a strong background in privacy, data protection, and IT/IS business solutions, FX is also passionate about fintech, insurtech, and cleantech. He combines his technical expertise with excellent communication and relationship management skills to guide his business partners to success.

Tabela de conteúdos

Fique por dentro das novidades do setor e dicas da Geotab

Publicações relacionadas

Geotab atinge 300 mil assinaturas e lidera gestão de frotas na América Latina

10 de abril de 2025

2 minutos de leitura

.jpg)

Gestão de riscos de frota: Guia completo para segurança e eficiência da sua frota

31 de março de 2025

5 minutos de leitura

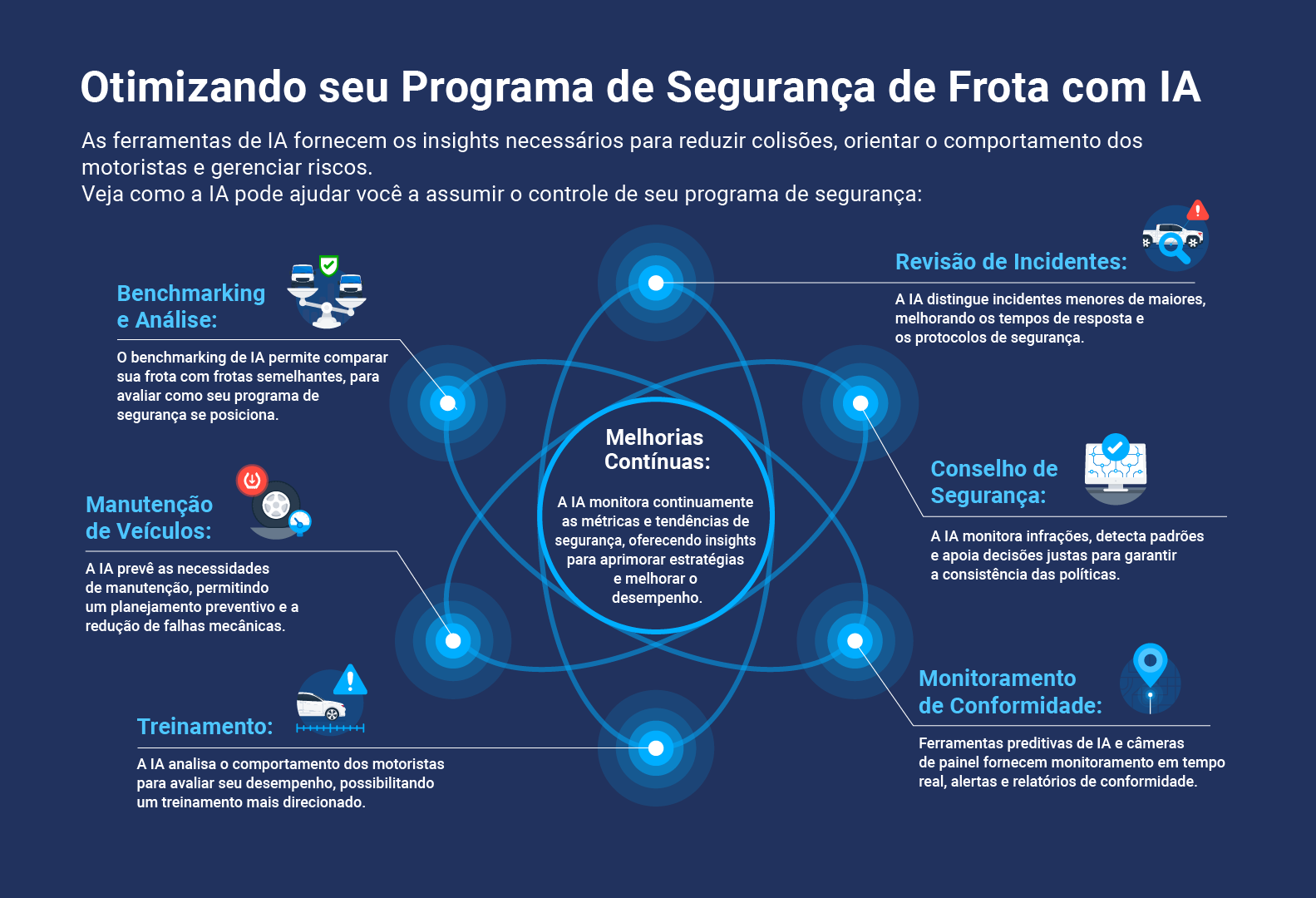

Como otimizar o seu programa de segurança da frota com IA

18 de março de 2025

1 minutos de leitura

Proteção de dados: Como garantimos a segurança dos nossos clientes

14 de março de 2025

2 minutos de leitura

%20(1).jpeg)

Como garantir transparência e uma interpretação mais precisa na inteligência artificial?

11 de março de 2025

4 minutos de leitura

Guia Completo: Gestão de combustível da frota e análise de KPIs para redução de custos

28 de fevereiro de 2025

4 minutos de leitura